BTS - Before The Scenes

Kurzbeschreibung

Was wäre, wenn Angela Merkel zu Eröffnungsfeier unserer Ausstellung im Lux gekommen wäre? Wenn Sam Altman uns in einer Videobotschaft dankt, für unsere spannenden Recherchen und KI-Projekte? Was wäre, wenn wir eine gesamte Ausstellung geplant und gebaut haben und davon einen Videobeweis hätten? Was wäre, wenn unsere Erinnerungen nicht mehr aus realen Erlebnissen, sondern aus generierten Fiktionen bestünden?

Unser Projekt Before The Scenes geht dieser Frage auf den Grund, indem wir eine vollständig synthetische Erinnerung unseres Masterkurses erschaffen. Mit Hilfe generativer KI kreieren wir eine Fake-Dokumentation, die scheinbare "Hinter-den-Kulissen"-Momente unseres Studienprojekts inszeniert. Durch den gezielten Einsatz von Deepfake-Technologien und inszenierten Interviews hinterfragen wir die Konstruktion von Authentizität und zeigen auf, wie formbar Erinnerungen durch digitale Medien sein können.

Die Idee dahinter

Erinnerungen sind flüchtig, subjektiv und wandelbar. Neurowissenschaft zeigt, dass sie keine festen Aufzeichnungen sind, sondern jedes Mal, wenn wir uns erinnern, neu rekonstruiert werden. Dabei können sich Details verändern oder sogar komplett falsch sein – ein Phänomen, das als False Memories bekannt ist. (https://www.pnas.org/doi/10.1073/pnas.2026447118)

KI-generierte Inhalte werden immer realistischer und dabei wollten wir untersuchen, wie leicht sich Erinnerungen konstruieren oder manipulieren lassen. Statt einer klassischen Dokumentation unserer Ausstellung im Lux zu erstellen, haben wir uns entschieden ein “Behind The Scenes” zu erschaffen, dass es so nie gegeben hat.

Mit generativer KI haben wir Bildmaterial, Deepfakes und gescriptete Interviews erstellt, die ein scheinbar authentisches Bild unserer Ausstellungsvorbereitungen vermitteln. Dabei haben wir uns bewusst für eine Mischung aus realen und künstlichen Elementen entschieden, um die Grenzen der Wahrnehmung herauszufordern. Der kreative Prozess

Umsetzung

1. Fragenhagel & Charakterentwicklung

Um unsere Fake-Dokumentation überzeugend zu gestalten, haben wir 16 Charaktere entwickelt – basierend auf realen Personen unseres Kurses. Jede Figur erhielt eine eigene Biografie, bestimmte sprachliche Eigenheiten und einen visuellen Stil. Mithilfe eines Templates generierten wir Antworten auf Fragen wie:

Was ist eine Erinnerung? Was sind Herausforderungen im Projekt? Wie lief die Eröffnung der Ausstellung? Was bedeutet Authentizität für dich? Spannend war, dass für die Ausführlichkeit der Antworten vor allem der Teil des Templates “[...] und antworte ganz kurz auf die [...]” entscheidend war. Je nach verwendeten Worten entstanden unterschiedlich lange Texte:

- “antworte super knapp”: 4-6 Wörter

- “antworte sehr knapp”: 3-10 Wörter

- “antworte eher knapp”: 15 - 25 Wörter

- “antworte”: 34 - 59 Wörter

2. Deep Fake Interviews - Der Prozess

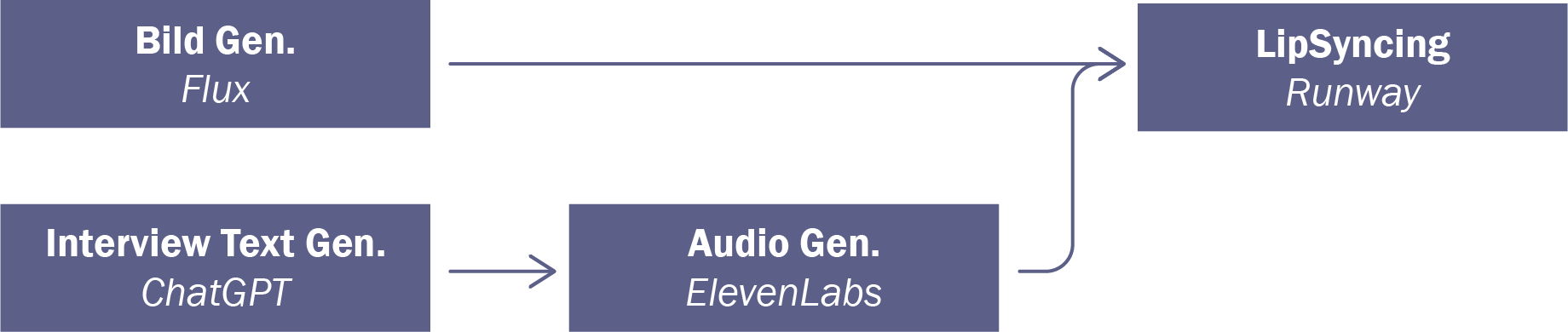

Ein zentraler Teil des Projekts sind die Interviews, die in kurzen Ausschnitten in das Video einfließen sollen. Um Videos mit authentischer Sprache von fiktiven Student*innen zu realisieren, wollten wir dieser groben Pipeline folgen:

Auf der Grundlage der ersten Tests (siehe Beispiel oben) haben wir die Pipeline angepasst, da wir drei wichtige Erkenntnisse gewonnen haben:

- Die Ausgangsbilder müssen bereits authentisch sein → Einsatz von Loras

- Die reine Audiospur als Ausgang für die Video generierung reicht nicht aus. Für eine authentische Mimik ist eine Videoreferenz erforderlich.

- Ein Foto als Ausgangsmaterial für LipSyncing führt zu einem starren Ergebnis → nicht authentisch

Nach den Anpassungen sah unsere Pipeline wie folgt aus:

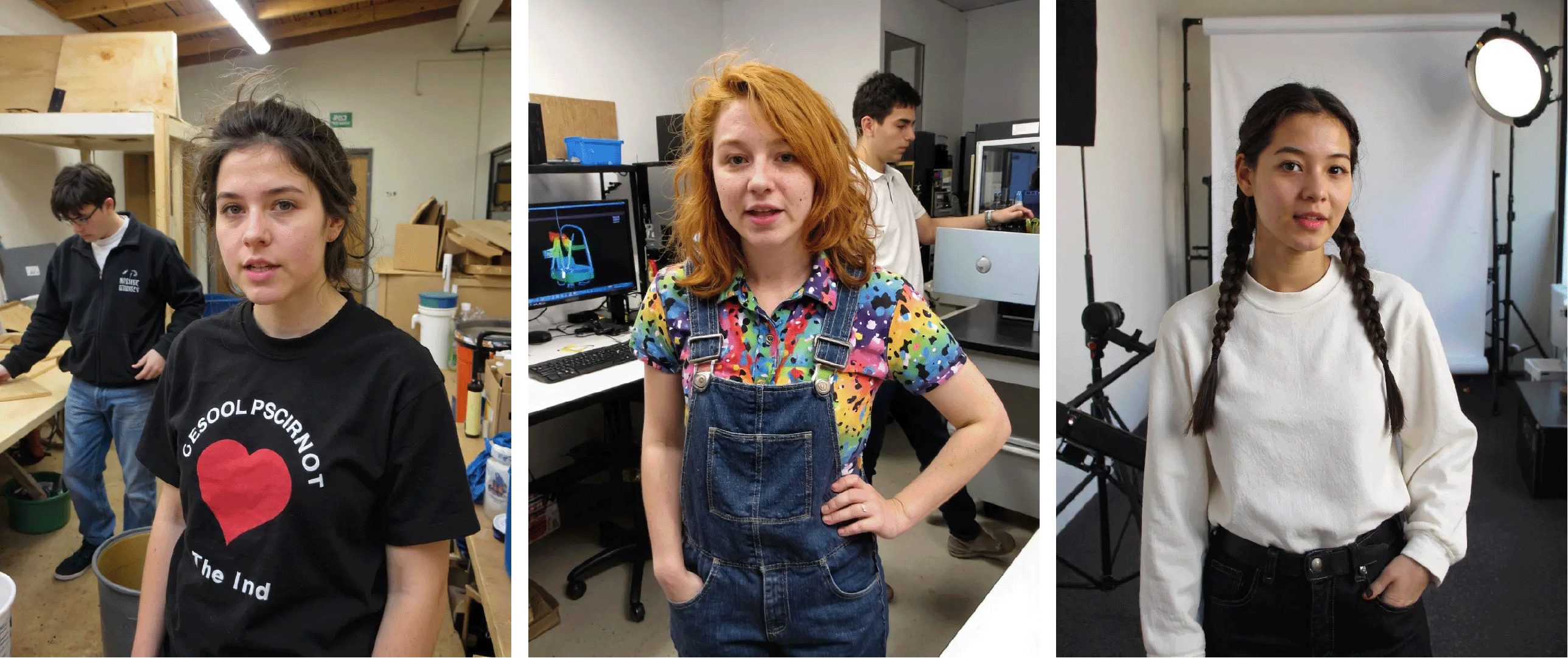

Nachdem die ersten Tests gezeigt haben, dass die Ausgangsbilder natürlicher werden müssen, haben wir vor allem mit den beiden Loras cavhs und amateurphoto experimentiert. Durch die richtige Gewichtung der Loras haben wir zuerst in Stable Diffusion recht authentische Bilder erhalten:

Beispielprompt:

wide amateur photograph of a female design student, talking, wavy light brown hair with a short fringe, portrait, frontal, standing in a messy wood workshop, people working in the back <lora:amateurphoto-6version:1.4: 1.5> ,<lora:CAVHS_flux_lora_v1:1.4>

In Flux konnten nur mit der “Amateurphoto” Lora (Gewichtung 0,9-1,1) ähnliche Ergebnisse erzielt werden, die dann als Ausgangspunkt für die restliche Pipeline verwendet werden konnten.

Beispielprompt:

wide amateur photograph of a female design student, talking, Medium-length messy red curls, freckles, wears overall with colorful shirt, portrait, frontal, standing in a laboratory room with sensors, powerful computers and AI training software, in the background a student touching a sensor

Aus den generierten Bildern wird im ersten Schritt von Krea AI mit dem Modell Hailuo ein Video erzeugt mit einem Prompt ähnlich zu diesem:

female student talking to the camera, static camera, people in the background working with wood

Wichtig war uns die Sprache, die natürliche Bewegung und dass auch im Hintergrund etwas passiert. Der von Runway angebotene Service ActOne kombiniert dann Mimik und Sprache eines vorhandenen Videos mit dem neu generierten. Das Ergebnis ist eine natürlich wirkende Sprache.

Um die neue Pipeline im Gesamten zu testen, haben wir einen schlussendlich erfolgreichen Testlauf durchgeführt:

Auf die gleiche Art und Weise können wir Interviews über unsere Ausstellung kreieren und eine Illusion erschaffen, die erst auf den zweiten Blick entlarvt wird.

© Ein Projekt von Jennifer Zachlod und Carla Deyerberg